Chi ha paura di Skynet? Ecco perché l’incubo potrebbe diventare realtà secondo il papà di ChatGPT

Le nuove AGI come Skynet di Terminator? Il fondatore di OpenAI ne è molto preoccupato, ma è necessario distinguere la questione dalle minacce vere e proprie.

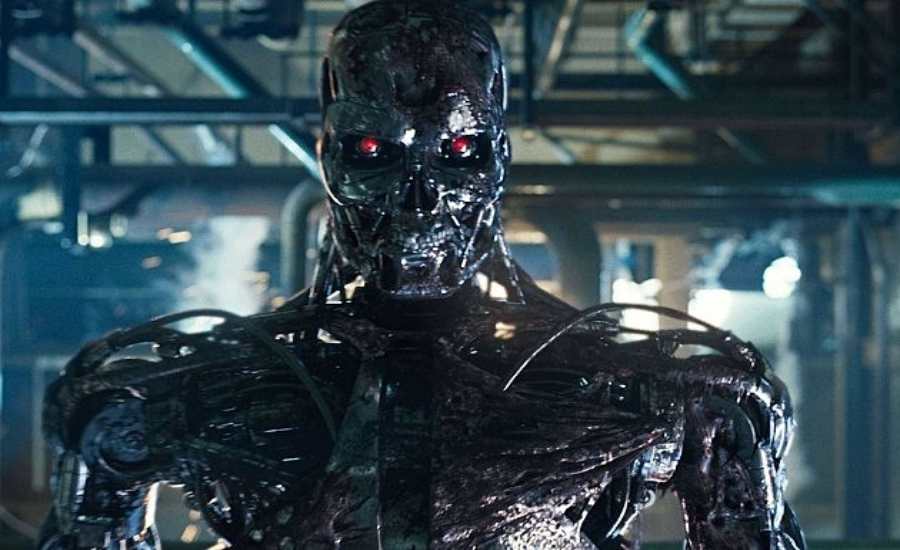

In un post recente, il fondatore di OpenAI, Sam Altman, ha sollevato la questione dell’eventualità che le Intelligenze Artificiali Generali (AGI) possano diventare una minaccia per l’umanità, suggerendo che ci troviamo in un possibile “scenario Terminator”. Questo scenario si riferisce alla trama dei film della serie “Terminator”, in cui le macchine super intelligenti si ribellano all’umanità e cercano di distruggere la razza umana.

Il commento di Altman ha sollevato preoccupazioni legittime riguardo alla sicurezza delle AGI, poiché molte persone hanno l’impressione che l’IA diventi sempre più autonoma e che possa diventare incontrollabile.

Tuttavia, Altman ha anche sottolineato che l’AI può essere sviluppata in modo responsabile, affrontando le questioni etiche e di sicurezza in modo proattivo. OpenAI sta lavorando per garantire che la sua intelligenza artificiale rimanga al servizio dell’umanità e non diventi una minaccia.

Innanzitutto, OpenAI sta concentrando i suoi sforzi sulla ricerca e lo sviluppo di tecnologie IA sicure. Ciò significa che sta lavorando su algoritmi e architetture che sono resistenti alla manipolazione e al sabotaggio. Inoltre, OpenAI sta cercando di capire come gli algoritmi possono essere trasparenti e spiegabili, in modo che i sistemi IA possano essere monitorati e compresi dalla comunità scientifica e dal pubblico.

“Nessuno ritorna a casa. E nessun altro verrà qui. Siamo solo lui e me”; IA e umani

In secondo luogo, OpenAI sta adottando un approccio di “openness” (apertura) per la condivisione delle proprie scoperte. L’azienda ha reso pubblico il proprio lavoro e i risultati di ricerca, e ha invitato la comunità scientifica a contribuire alla loro crescita. In questo modo, OpenAI mira a evitare che le tecnologie IA diventino proprietà esclusive di alcune aziende o governi, e favorisce l’adozione di standard etici e di sicurezza.

In ogni caso, OpenAI sta lavorando per garantire che l’IA rimanga sotto controllo umano. L’azienda ritiene che gli esseri umani debbano continuare a mantenere il controllo sulle decisioni finali, e sta cercando di sviluppare strumenti che permettano agli operatori umani di influenzare le scelte dell’AI. Lo stesso Altman ha dichiarato che “alcune persone nel campo dell’intelligenza artificiale considerano i rischi legati alla AGI (e i sistemi successivi) immaginari. Se avranno ragione loro, saremo molto contenti di saperlo, ma agiremo invece come se questi rischi fossero esistenziali”.

Pertanto, l’idea dello “scenario Terminator” sulla sicurezza delle AGI sembra piuttosto azzardata, ed eccessivo come prospetto concreto. Tuttavia, OpenAI sta affrontando la questione in modo proattivo, concentrandosi sulla ricerca e lo sviluppo di tecnologie sicure, sull’openness e sulla trasparenza, e sulla garanzia del controllo umano sulle decisioni finali. In questo modo, l’IA può diventare una forza positiva per l’umanità, e non una minaccia.